Shadow AI et formation : sécuriser l'usage de l'IA dans votre agence.

45,8 % des requêtes aux LLM exposent des données clients : découvrez comment former vos collaborateurs et sécuriser l'usage de l'IA dans votre agence.

L'intelligence artificielle transforme les métiers de la communication et de la publicité. Selon une étude récente sur les pratiques des communicants en 2025, 93 % des communicants ont déjà utilisé l'IA dans leur travail, dont 55 % de manière régulière en agence. Cette adoption massive se fait pourtant sans encadrement, exposant les structures à des risques majeurs : fuites de données confidentielles, non-conformité réglementaire et utilisation incontrôlée du Shadow AI.

Former efficacement ses collaborateurs ne nécessite pas forcément d'investir dans des formations certifiantes. De nombreuses ressources gratuites ou accessibles permettent de monter en compétences tout en instaurant une gouvernance IA solide.

Les risques à adresser en priorité

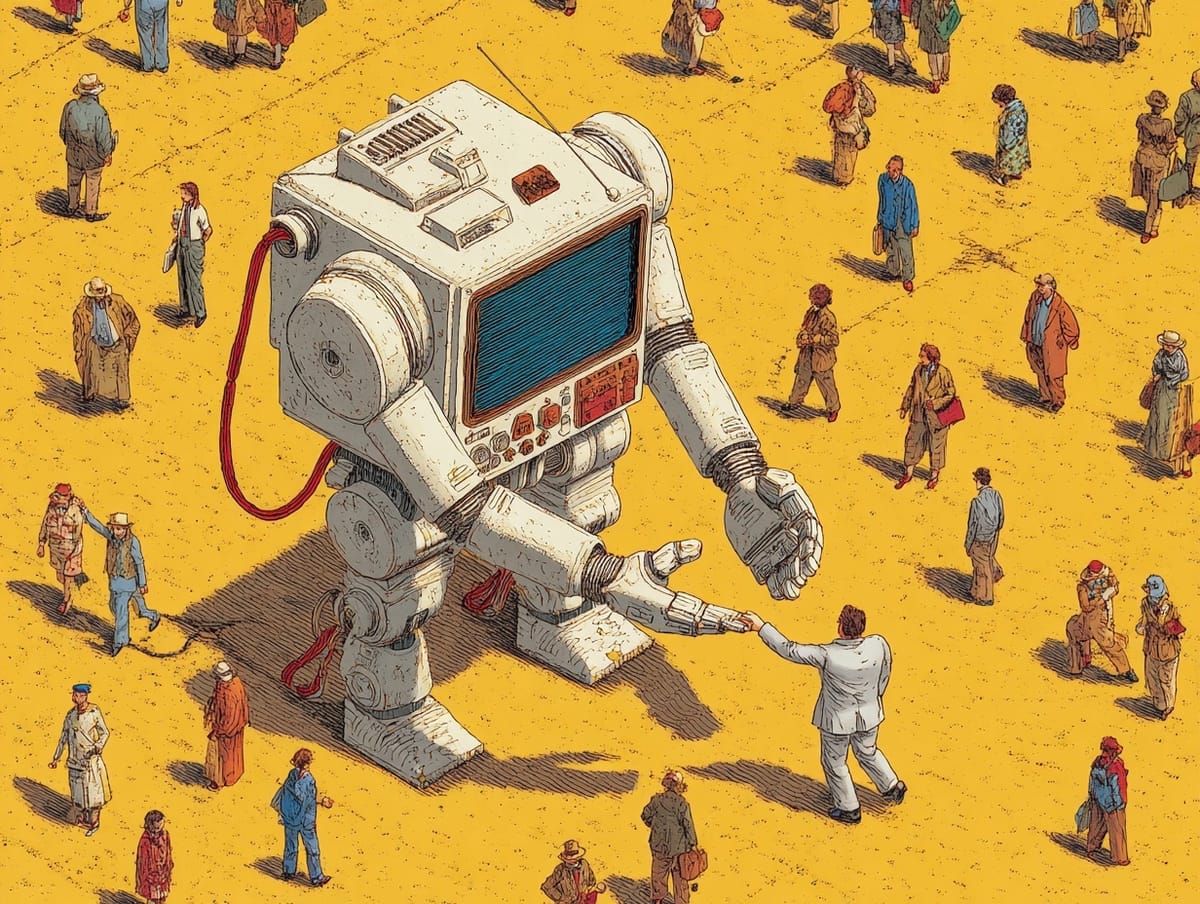

Le Shadow AI, menace invisible

Le Shadow AI désigne l'utilisation non autorisée d'outils d'IA par les collaborateurs sans supervision de l'entreprise. Concrètement : un commercial qui colle un contrat client dans ChatGPT pour en résumer les points clés, ou un RH qui fait analyser un CV contenant des informations personnelles par un outil externe.

Les chiffres parlent d'eux-mêmes : 20 % des violations de données mondiales impliquent désormais des systèmes de Shadow AI. Chaque prompt contenant une information confidentielle peut créer une fuite instantanée. Les données saisies sont stockées sur des serveurs étrangers, utilisées pour l'entraînement des modèles ou exposées à des tiers sans contrôle.

L'AI Act européen : des obligations dès 2025

Le Règlement européen sur l'intelligence artificielle s'applique progressivement depuis août 2024. Toute entreprise qui déploie ou exploite un système d'IA est concernée, du fournisseur de solution au simple utilisateur dans les directions métiers.

Principales échéances : depuis février 2025, les interdictions pour les usages à risque inacceptable sont appliquées. À partir d'août 2025, des obligations spécifiques concernent les modèles d'IA à usage général comme GPT, Gemini ou Claude. La pleine application pour les systèmes à haut risque interviendra en août 2027.

L'AI Act stipule explicitement que les fournisseurs et utilisateurs de systèmes d'IA doivent prendre des mesures pour assurer un niveau suffisant de connaissances en matière d'IA à leur personnel. La formation devient donc une obligation de conformité.

Les fuites de données confidentielles

L'étude Harmonic Security révèle d'autres chiffres alarmants : 45,8 % des requêtes envoyées aux LLM risquaient d'exposer des données clients, notamment liées à la facturation et à l'authentification, et 26,8 % des prompts contenaient des données RH liées à la paie ou à des identifiants personnels.

Dans les agences de communication, les risques typiques incluent la transmission de briefs clients confidentiels, de structures de prix, de données de campagnes non publiques ou de stratégies marketing vers des outils IA non sécurisés.

Ressources gratuites et charte IA : contenu réservé aux membres

Les risques sont identifiés, les obligations légales sont claires. Il est maintenant temps de passer à l'action avec les solutions concrètes : un panorama complet des ressources gratuites pour former vos équipes (OpenAI Academy, Google AI Skills, Microsoft, AWS...) et un modèle de charte IA prêt à l'emploi, conforme à l'AI Act et au RGPD.

Ce contenu détaillé est réservé aux membres de la communauté. Connectez-vous ou créez votre compte gratuit pour accéder immédiatement aux ressources de formation et au template de charte IA que vous pourrez adapter à votre agence.